K8S标签与标签选择器

文章目录

- 一、标签

- 1、简介

- 2、为什么需要标签

- 3、标签命名规范

- 3.1、标签名

- 3.2、标签的value

- 4、标签的基本操作

- 4.1、创建标签

- 4.1.1、资源清单方式

- 4.1.2、命令行方式

- 4.2、查看标签

- 4.2.1、查看刚才打标的两个pod

- 4.2.2、通过标签过滤查询

- 4.2.3、将标签显示在输出结果中

- 4.3、添加标签

- 4.3.1、分别给两个Pod添加上标签

- 4.4、更新标签

- 4.4.1、将nginx-test的app标签键值修改为nginx-test

- 4.5、删除标签

- 4.5.1、删除两个Pod的environment标签

- 二、标签选择器

- 1、简介

- 2、表达式

- 2.1、基于等式的

- 2.2、基于集合的

- 3、过滤查询

- 3.1、等值过滤

- 3.2、非等值过滤

- 3.3、多条件过滤

- 3.4、多条件取反过滤

- 4、service资源对象关联对应标签的Pod

- 4.1、创建三个Pod

- 4.2、创建service对象关联对应标签的Pod

- 4.2.1、创建service资源清单

- 4.2.2、应用清单

- 4.2.3、验证

一、标签

1、简介

标签是附在k8s 资源对象的一组键值对,其存在的意义是按照用户的意图来组织资源,同时不对资源的核心逻辑产生影响。

标签的使用我们倾向于能够表示对象的特殊特点,就是一眼就看出了这个Pod是干什么的。

标签可以用来划分特定的对象(比如版本,服务类型等),标签可以在创建一个对象的时候直接定义,也可以在后期随时修改,每一个对象可以拥有多个标签,但是,key值必须是唯一的。

创建标签之后也可以方便我们对资源进行分组管理。如果对pod打标签,之后就可以使用标签来查看、删除指定的pod。

2、为什么需要标签

我们知道使用 pod 控制器创建的 pod,在 pod 故障以后重建后的 pod ip 地址和名称是变化的,为了解决 pod 访问问题,我们特此创建了 service,我们访问 service 的 ip 地址就可以正常访问到 pod;那么问题来了,service 是怎样去关联 pod 的呢?

在 k8s 上是使用的标签和标签选择器的机制实现资源和资源间相互关联的。当我们创建一个Service时,会指定一个标签选择器,这个选择器定义了一组键值对,用以匹配特定的Pods。Kubernetes的Service Controller会查找所有带有与选择器匹配标签的Pods,并将这些Pods的IP地址添加到Service的Endpoint中。因此,无论Pod的IP如何变化,只要它的标签与Service的选择器相匹配,它就能被Service发现和代理流量。

3、标签命名规范

3.1、标签名

- 标签名部分是必须的。

- 不能多余 63 个字符。

- 必须由字母、数字开始和结尾。

- 可以包含字母、数字、减号(-)、下划线(_)、小数点(.)

3.2、标签的value

- 不能多于 63 个字符。

- 可以为空字符串。

- 如果不为空,则必须由字母、数字开始和结尾。

- 如果不为空,可以包含字母、数字、减号(-)、下划线(_)、小数点(.)

apiVersion: v1 kind: Pod metadata: name: label-demo labels: #标签 environment: production app: nginx spec: containers: - name: nginx image: nginx:1.14.2 ports: - containerPort: 804、标签的基本操作

4.1、创建标签

4.1.1、资源清单方式

1、创建资源清单

cat pod_labels.yaml apiVersion: v1 kind: Pod metadata: name: nginx-test namespace: dev3 labels: app: nginx environment: production spec: containers: - name: nginx image: nginx env: - name: HELLO value: "hello pod labels test"2、应用清单

kubectl apply -f pod_labels.yaml

4.1.2、命令行方式

kubectl run nginx-labels -n dev4 --image=nginx --labels="app=nginx-labels,environment=production"

4.2、查看标签

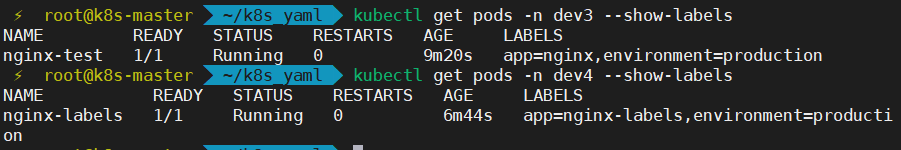

4.2.1、查看刚才打标的两个pod

kubectl get pods -n dev3 --show-labels kubectl get pods -n dev4 --show-labels

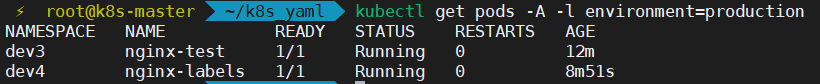

4.2.2、通过标签过滤查询

kubectl get pods -A -l environment=production #列出所有带有标签 environment=production 的 Pod

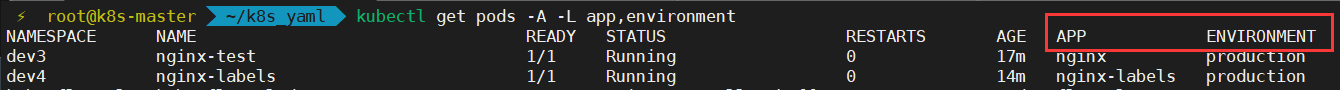

4.2.3、将标签显示在输出结果中

kubectl get pods -A -L app,environment

4.3、添加标签

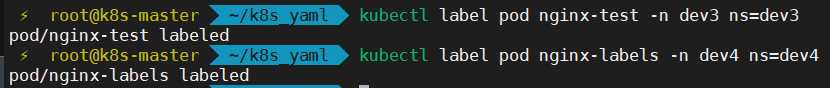

4.3.1、分别给两个Pod添加上标签

kubectl label pod nginx-test -n dev3 ns=dev3 kubectl label pod nginx-labels -n dev4 ns=dev4

4.4、更新标签

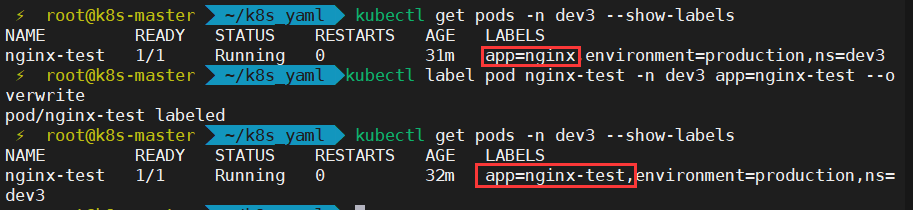

4.4.1、将nginx-test的app标签键值修改为nginx-test

kubectl label pod nginx-test -n dev3 app=nginx-test --overwrite

–overwirte在针对不存在的标签作用是添加

在针对存在的标签作用是更新修改

4.5、删除标签

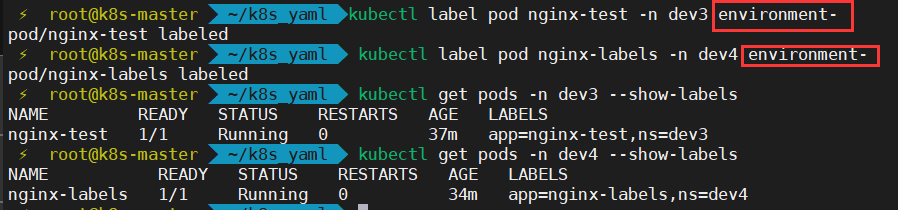

4.5.1、删除两个Pod的environment标签

kubectl label pod nginx-test -n dev3 environment- kubectl label pod nginx-labels -n dev4 environment-

其实无论是对Pods的标签基本操作还是对 Nodes、PersistentVolumes (PVs)、PersistentVolumeClaims (PVCs)、Services、Deployments、ReplicaSets、StatefulSets 这些资源对象来说,标签的基本操作都适用,使用时只需指定对应的资源类型即可

二、标签选择器

1、简介

Lablel附加到Kubernetes集群中的各种资源对象上,目的就是对这些资源对象进行分组管理,而分组管理的核心就是:Lablel Selector。

我们可以通过Label Selector(标签选择器)查询和筛选某些特定Label的资源对象,进而可以对他们进行相应的操作管理,类似于sql语句中where的条件:

select * from where ...

2、表达式

2.1、基于等式的

name = nginx 匹配所有具有标签 name = nginx 的资源对象 name != nginx 匹配所有不具有标签 name = nginx 的资源对象

2.2、基于集合的

env in (dev, test) 匹配所有具有标签 env = dev 或者 env = test 的资源对象 name not in (frontend) 匹配所有不具有标签 name = frontend 的资源对象

3、过滤查询

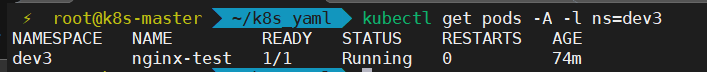

3.1、等值过滤

kubectl get pods -A -l ns=dev3 #过滤出带有ns=dev3标签的Pod

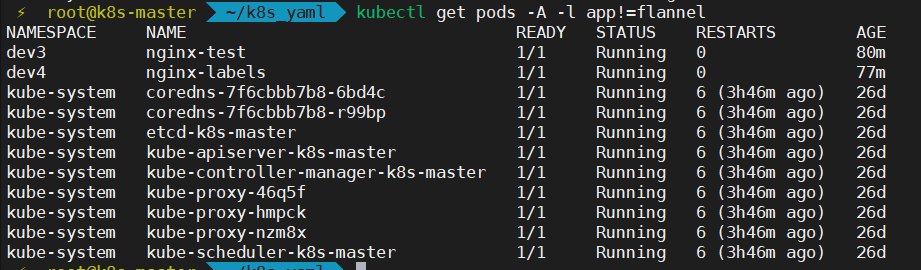

3.2、非等值过滤

kubectl get pods -A -l app!=flannel #过滤出不带标签app=flannel的Pod

3.3、多条件过滤

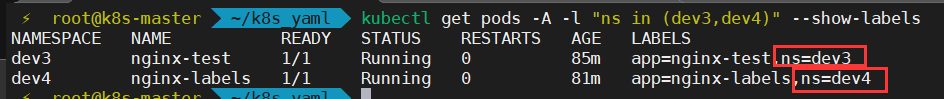

kubectl get pods -A -l "ns in (dev3,dev4)" --show-labels #过滤出包含ns=dev3或ns=dev4的Pod

3.4、多条件取反过滤

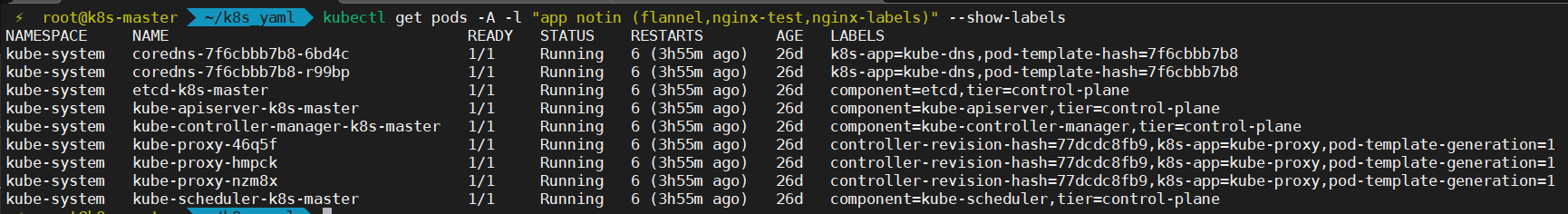

kubectl get pods -A -l "app notin (flannel,nginx-test,nginx-labels)" --show-labels #过滤出标签中不包含app=(flannel,nginx-test,nginx-labels)的Pod

4、service资源对象关联对应标签的Pod

4.1、创建三个Pod

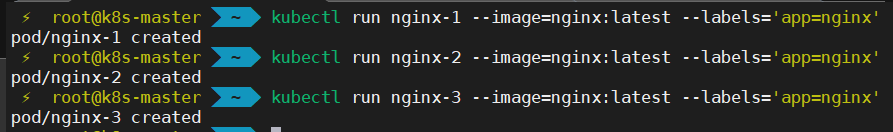

kubectl run nginx-1 --image=nginx:latest --labels='app=nginx' kubectl run nginx-2 --image=nginx:latest --labels='app=nginx' kubectl run nginx-3 --image=nginx:latest --labels='app=nginx'

4.2、创建service对象关联对应标签的Pod

4.2.1、创建service资源清单

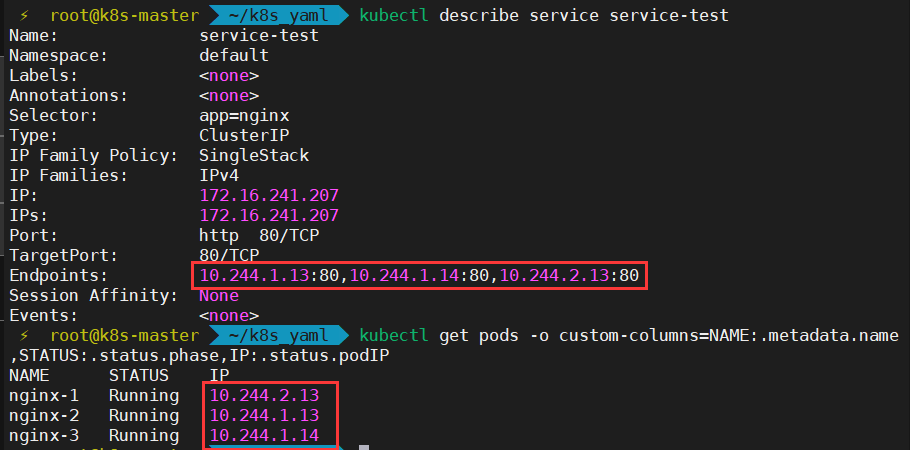

apiVersion: v1 kind: Service metadata: name: service-test spec: selector: app: nginx ports: - name: http protocol: TCP port: 80 targetPort: 804.2.2、应用清单

kubectl apply -f service-test.yaml

4.2.3、验证

kubectl describe service service-test kubectl get pods -o custom-columns=NAME:.metadata.name,STATUS:.status.phase,IP:.status.podIP