大语言模型:Query Rewriting for Retrieval-Augmented Large Language Models

温馨提示:这篇文章已超过373天没有更新,请注意相关的内容是否还可用!

总体思路

- 作者首先指出大语言模型虽然取得了很好的效果,但是仍然存在幻觉和时间顺序混乱的问题,因此需要额外知识库和LLM内部知识库相结合,来修正;

- 因此优化传统的retriever-reader的方案成为需要;

- 目前的研究方案当中使用prompt优化的方法是黑盒的不可修改;

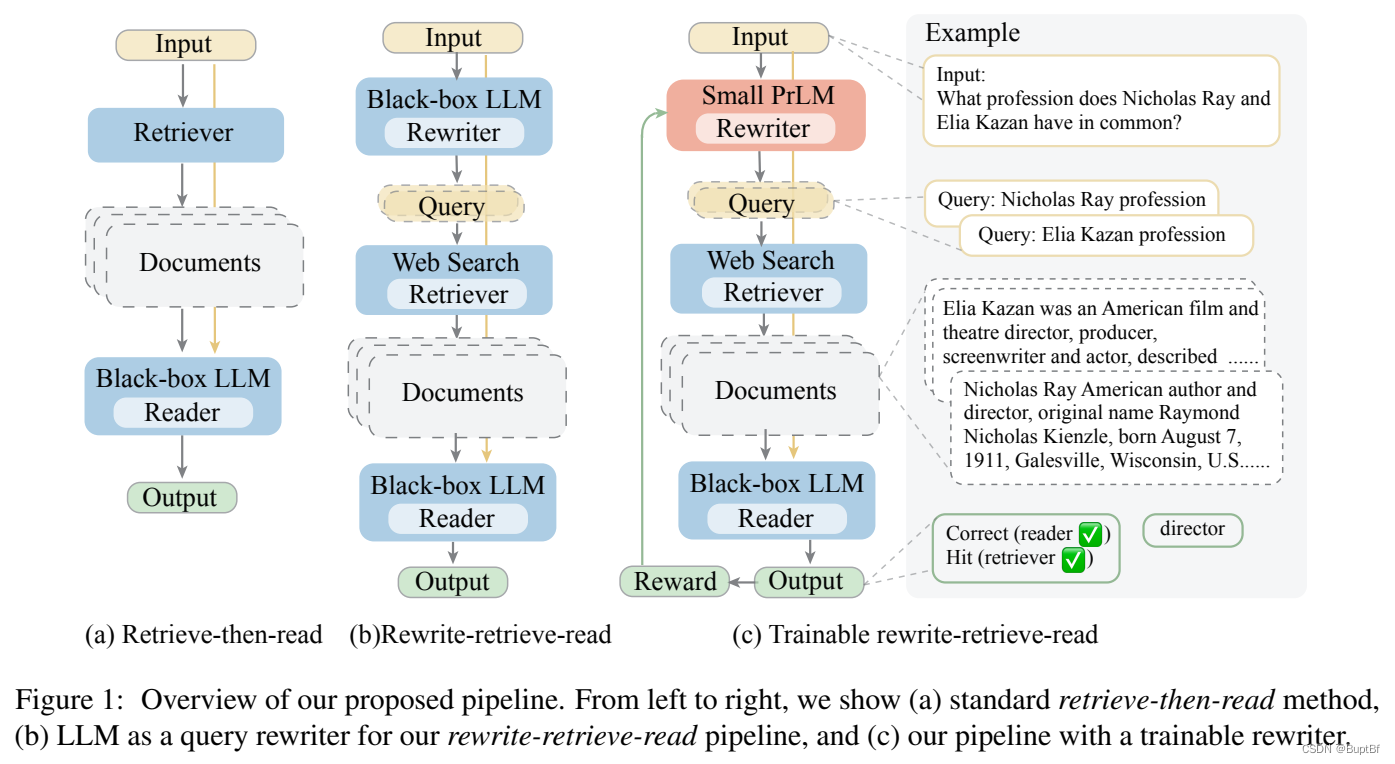

- 因此作者提出了采用大模型重写query的rewrite的方法来优化;

- 同时作者也提出这种重写的方法可以不是局限于大语言模型的,直接使用可训练的语言模型也能完成相关任务;

- 在实验当中这种方法对下游任务reader的效果取得了良好的效果。(也就是没有直接评测,而是评测了下游任务)

直接看这个图大致就可以获得作者提出的方案和原始方案的区别了。

训练细节

- 作者基础版本的使用LLM的rewriter当中也是使用meta-prompt进行query改写;

- 作者在训练版本使用了T5作为被训练模型,在开始真正训练之前,因为T5模型本身不能完成这个query获取的任务,因此先使用pseudo数据进行训练,使得其具有这个能力,这些数据就是上一步LLM实现query改写获得的数据;

- 在训练的过程中主要有几个组成:状态(序列×字母可能性)、动作、概率(实际上的改写策略,默认是上一步预热得到的模型)、reward(使用结果得出的结论)、γ(最终得到的reader输出结果,有无限多种)的强化学习方法

免责声明:我们致力于保护作者版权,注重分享,被刊用文章因无法核实真实出处,未能及时与作者取得联系,或有版权异议的,请联系管理员,我们会立即处理! 部分文章是来自自研大数据AI进行生成,内容摘自(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供学习参考,不准确地方联系删除处理! 图片声明:本站部分配图来自人工智能系统AI生成,觅知网授权图片,PxHere摄影无版权图库和百度,360,搜狗等多加搜索引擎自动关键词搜索配图,如有侵权的图片,请第一时间联系我们,邮箱:ciyunidc@ciyunshuju.com。本站只作为美观性配图使用,无任何非法侵犯第三方意图,一切解释权归图片著作权方,本站不承担任何责任。如有恶意碰瓷者,必当奉陪到底严惩不贷!