【 LayoutLM】 LayoutLMv3---统一的文本和图像掩码来预训练文档 AI 的多模态 Transformer

LayoutLMv3

Paper : LayoutLMv3 :Pre-training for Document AI with Unified Text and Image Masking

Author :Yupan Huang,Tengchao Lv,Lei Cui,Yutong Lu, Furu Wei

Affiliation : Microsoft Azure AI ,Sun Yat-sen University

Publication:ACM-Multimedia-2022

Code : https://aka.ms/layoutlmv3.

统一的文本和图像掩码来预训练文档 AI 的多模态 Transformer

单词补丁对齐目标进行预训练

LayoutLMv3 是文档 AI 中第一个多模态模型,不依赖于预训练的 CNN 或 Faster R-CNN 主干来提取视觉特征,这显著节省了参数并消除了区域注释。

0 前景

自监督预训练技术在文档人工智能方面取得了显着的进步。大多数多模态预训练模型使用掩码语言建模目标来学习文本模态的双向表示,但它们在图像模态的预训练目标上有所不同。这种差异增加了多模态表示学习的难度。

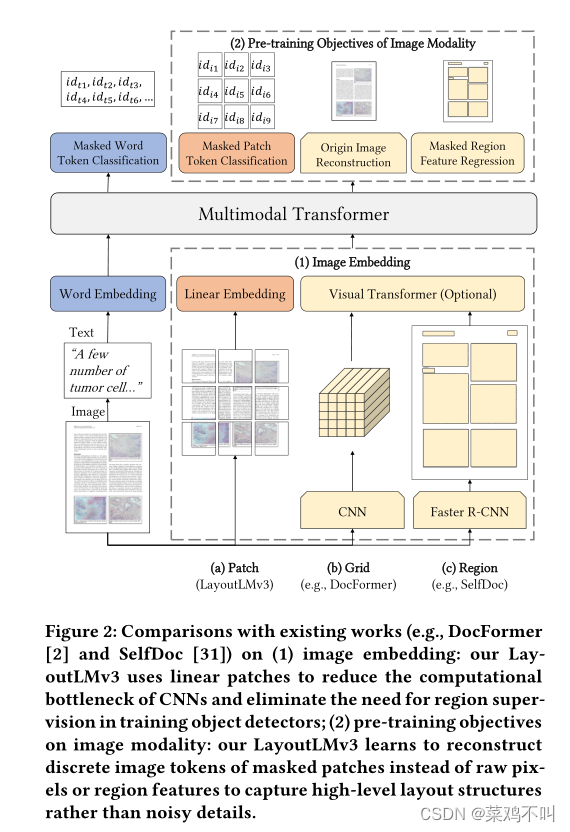

自监督预训练技术由于其重建预训练目标的成功应用,在表示学习方面取得了快速进展。在 NLP 研究中,BERT 首先提出了“掩码语言建模”(MLM),通过根据上下文预测随机掩码词token的原始词汇 ID 来学习双向表示。尽管大多数高性能多模态预训练文档 AI 模型都使用 BERT 提出的文本模态 MLM,但它们在图像模态的预训练目标上有所不同。例如,DocFormer 学习通过 CNN 解码器重建图像像素 ,它倾向于学习嘈杂的细节,而不是高级结构,例如文档布局 。 SelfDoc 提出回归屏蔽区域特征,这比在较小词汇量中对离散特征进行分类噪音更大且更难学习。图像(例如,密集图像像素或连续区域特征)和文本目标(即离散tokens)的不同粒度进一步增加了跨模态对齐学习的难度,而这对于多模态表示学习至关重要。

为了克服文本和图像模态预训练目标的差异并促进多模态表示学习,作者提出 LayoutLMv3 来预训练文档 AI 的多模态 Transformer,具有统一的文本和图像掩蔽目标 MLM 和 MIM。

1 方法

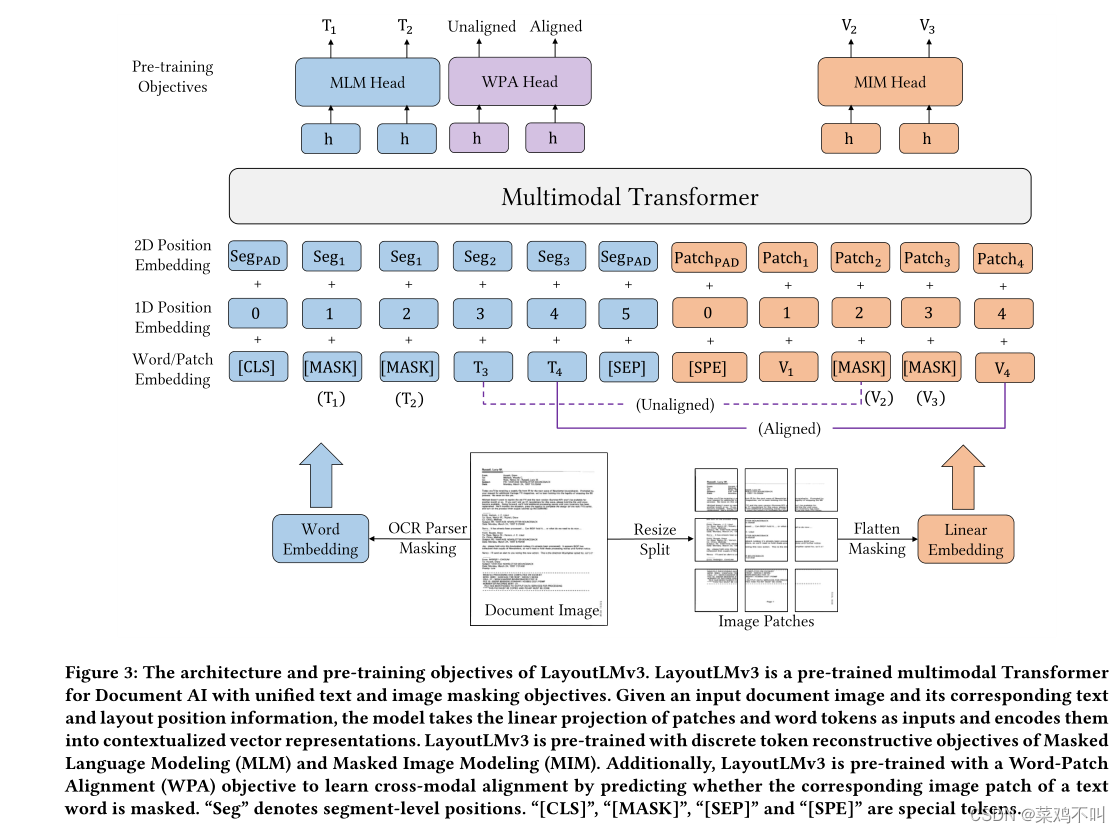

LayoutLMv3 学习重建文本模态的屏蔽词标记,并对称地重建图像模态的屏蔽补丁标记。受 DALL-E 和 BEiT的启发,作者从离散 VAE 的潜在代码中获取目标图像tokens。对于文档,每个文本单词对应一个图像块。为了学习这种跨模态对齐,作者提出了word-patch对齐(WPA)目标来预测文本单词的相应图像补丁是否被屏蔽。

受 ViT 和 ViLT 的启发,LayoutLMv3 直接利用文档图像中的原始图像补丁,无需复杂的预处理步骤(例如页面对象检测)。 LayoutLMv3 在 Transformer 模型中联合学习图像、文本和多模态表示,具有统一的 MLM、MIM 和 WPA 目标。这使得 LayoutLMv3 成为第一个无需 CNN 进行图像嵌入的多模态预训练文档 AI 模型,可显著节省参数并摆脱区域注释。简单的统一架构和目标使 LayoutLMv3 成为适用于以文本为中心的任务和以图像为中心的文档 AI 任务的通用预训练模型。

1.1 Text Embedding

文本嵌入是词嵌入和位置嵌入的组合。作者使用现成的 OCR 工具包对文档图像进行预处理,以获得文本内容和相应的 2D 位置信息。我们使用预训练模型 RoBERTa 中的词嵌入矩阵来初始化词嵌入。位置嵌入包括 1D 位置和 2D 布局位置嵌入,其中 1D 位置是指文本序列中标记的索引,2D 布局位置是指文本序列的边界框坐标。遵循 LayoutLM,作者通过图像的大小标准化所有坐标,并使用嵌入层分别嵌入 x 轴、y 轴、宽度和高度特征 。 LayoutLM和LayoutLMv2采用词级布局位置,每个词都有其位置。相反,作者采用段级布局位置,段中的单词共享相同的2D位置,因为单词通常表达相同的语义。

1.2 Image Embedding

Document AI 中现有的多模态模型要么提取 CNN 网格特征,要么依赖 Faster R-CNN 等对象检测器来提取图像嵌入的区域特征,这占了严重的计算瓶颈或需要区域监督。受 ViT 和 ViLT 的启发,作者在将文档图像输入多模态 Transformer 之前,用图像块的线性投影特征来表示文档图像。具体来说,我们将文档图像的大小调整为 H × W 并用 I ∈ R H × W × C I ∈ R^{H×W×C} I∈RH×W×C 表示图像,其中 C、W 和 H 分别是图像的通道大小、宽度和高度。然后,作者将图像分割成一系列均匀的 P × P 块,将图像块线性投影到 D 维度,并将它们展平为向量序列,其长度为 M= HW/ P 2 P^2 P2。然后,作者向每个补丁添加可学习的 1D 位置嵌入,因为作者在初步实验中没有观察到使用 2D 位置嵌入带来的改进。 LayoutLMv3 是 Document AI 中第一个不依赖 CNN 提取图像特征的多模态模型,这对于 Document AI 模型减少参数或删除复杂的预处理步骤至关重要。

作者将语义 1D 相对位置和空间 2D 相对位置作为偏差项插入到遵循 LayoutLMv2的文本和图像模态的自注意力网络中。

1.3 预训练目标

LayoutLMv3 使用 MLM、MIM 和 WPA 目标进行预训练,以自监督学习方式学习多模态表示。 LayoutLMv3 的完整预训练目标定义为

L = L M L M + L M I M + L W P A L=L_{MLM}+L_{MIM}+L_{WPA} L=LMLM+LMIM+LWPA

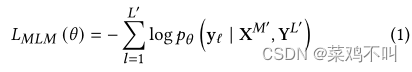

1.3.1 Masked Language Modeling (MLM)

对于语言方面,作者的 MLM 受到 BERT 中的屏蔽语言建模以及 LayoutLM 和 LayoutLMv2 中的屏蔽视觉语言建模的启发。我们使用跨度掩码策略来掩码 30% 的文本标记,跨度长度取自泊松分布 ( λ \lambda λ = 3) 。预训练的目标是基于图像tokens X M ′ X^{M'} XM′ 和文本标记 Y L ′ Y_{L'} YL′ 的损坏序列的上下文表示,最大化正确屏蔽文本标记 y l y_l yl的对数似然,其中 M’和 L’ 表示屏蔽的文本标记职位。作者用 θ \theta θ 表示 Transformer 模型的参数,并最小化随后的交叉熵损失:

由于保持布局信息不变,这个目标有助于模型学习布局信息与文本和图像上下文之间的对应关系。

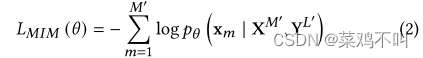

1.3.2 Masked Image Modeling (MIM)

为了鼓励模型从上下文文本和图像表示中解释视觉内容,将 BEiT 中的 MIM 预训练目标调整为多模态 Transformer 模型。 MIM 目标与 MLM 目标对称,即使用块屏蔽策略随机屏蔽约 40% 的图像token。 MIM 目标由交叉熵损失驱动,以在周围文本和图像标记的背景下重建屏蔽图像标记 x m x_{m} xm。

图像标记的标签来自图像tokenizer,它可以根据视觉词汇表将密集图像像素转换为离散tokens。因此,MIM 有助于学习高级布局结构,而不是嘈杂的低级细节。

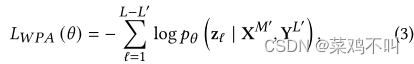

1.3.3 Word-Patch Alignment (WPA)

对于文档,每个文本单词对应一个图像块。由于作者分别使用 MLM 和 MIM 随机屏蔽文本和图像标记,因此文本和图像模态之间没有明确的对齐学习。

因此,作者提出了一个 WPA 目标来学习文本单词和图像块之间的细粒度对齐。 WPA 的目标是预测文本单词对应的图像块是否被屏蔽。具体来说,当对应的图像标记也未被屏蔽时,将对齐的标签分配给未被屏蔽的文本标记。

否则,作者分配一个未对齐的标签。作者在计算 WPA 损失时排除屏蔽文本标记,以防止模型学习屏蔽文本单词和图像块之间的对应关系。作者使用两层 MLP 头输入上下文文本和图像,并输出具有二进制交叉熵损失的二进制对齐/未对齐标签:

其中 L − L ′ L-L' L−L′是未屏蔽文本标记的数量, z ℓ z_ℓ zℓ是ℓ位置的语言标记的二进制标签。

2 实验

2.1 预训练 LayoutLMv3

为了学习各种文档任务的通用表示,在大型 IIT-CDIP 数据集上预训练 LayoutLMv3。 IITCDIP Test Collection 1.0是一个大规模扫描文档图像数据集,包含约1100万张文档图像,可分割为4200万页。只使用其中的 1100 万个来训练 LayoutLMv3。不按照 LayoutLM 模型进行图像增强。对于多模态 Transformer 编码器以及文本嵌入层,LayoutLMv3 是根据 RoBERTa的预训练权重进行初始化的。图像标记器是从 DiT 中预训练的图像标记器初始化的,DiT 是一种自监督的预训练文档图像 Transformer 模型。图像标记的词汇量为 8,192。随机初始化其余模型参数。我们使用 Adam 优化器 预训练 LayoutLMv3,批量大小为 2,048,步数为 500,000。使用 1e− 2 的权重衰减,并且 ( β 1 , β 2 ) (\beta_1, \beta_2) (β1,β2)= (0.9, 0.98)。对于 LayoutLMv3-BASE 模型,使用 1e − 4 的学习率,并在前 4.8% 的步骤中线性预热学习率。对于 LayoutLMv3LARGE,学习率和预热比分别为 5e − 5 和 10%。

2.2 多模态任务的微调

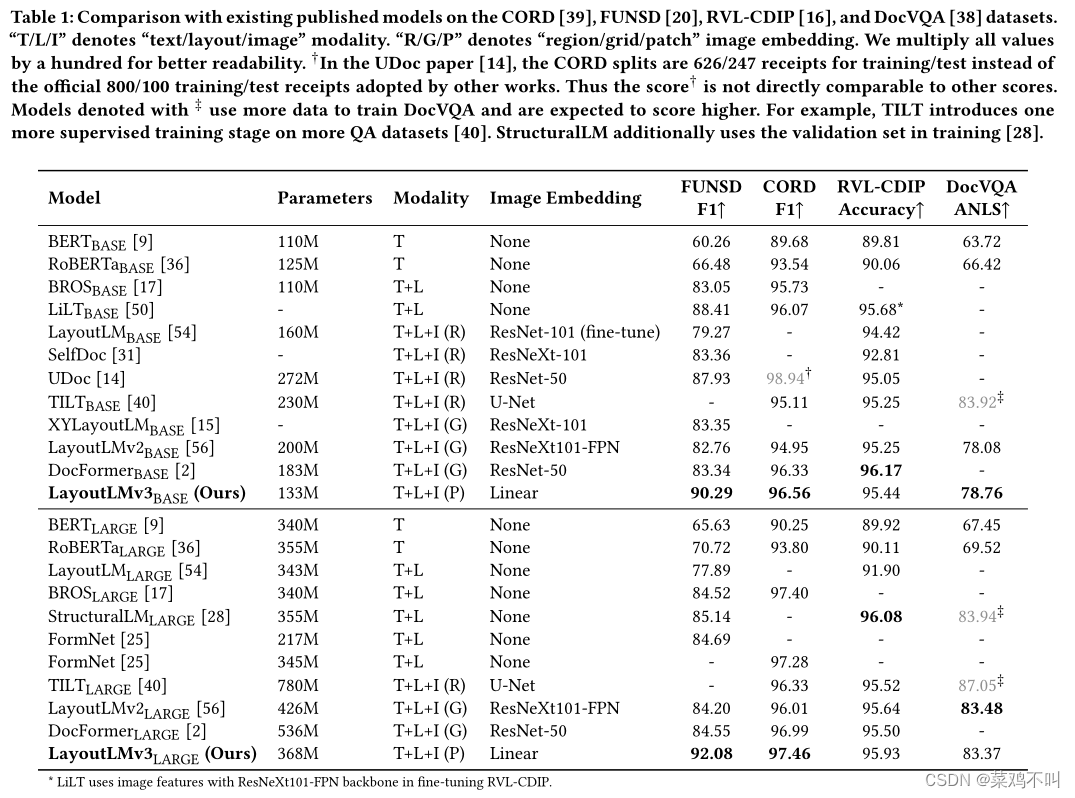

将 LayoutLMv3 与典型的自监督预训练方法进行比较,并按预训练方式对它们进行分类。

• [T] 文本模态:BERT 和 RoBERTa 是典型的预训练语言模型,仅使用具有 Transformer 架构的文本信息。我们使用来自 LayoutLM 的 RoBERTa 的 FUNSD 和 RVLCDIP 结果以及来自 LayoutLMv2 的 BERT 结果。我们重现并报告 RoBERTa 的 CORD 和 DocVQA 结果。

• [T+L] 文本和布局模式:LayoutLM 通过将字级空间嵌入添加到 BERT 的嵌入来合并布局信息。 StructuralLM 利用段级布局信息。 BROS 编码相对位置布局。LILT 使用预先训练的文本模型对不同语言进行微调 。 FormNet 利用表单中标记之间的空间关系。

• [T+L+I (R)] 具有 Faster R-CNN 区域特征的文本、布局和图像模态:这一系列工作从 Faster R-CNN 模型中的 RoI 头中提取图像区域特征。其中,LayoutLM和TILT 使用OCR单词的边界框作为区域建议,并将区域特征添加到相应的文本嵌入中。SelfDoc 和 UDoc使用文档对象建议并将区域特征与文本嵌入连接起来。

• [T+L+I (G)] 具有 CNN 网格特征的文本、布局和图像模态:LayoutLMv2 和 DocFormer 使用 CNN 主干提取图像网格特征,无需对象检测。 XYLayoutLM 采用LayoutLMv2的架构并改进了布局表示。

• [T+L+I (P)] 文本、布局和具有线性补丁特征的图像模态:LayoutLMv3 使用简单的线性嵌入替换 CNN 主干来对图像补丁进行编码。

在公开可用的基准上对多模式任务的 LayoutLMv3 进行了微调。结果如表1所示。

任务一:表格和收据理解。

表格和收据理解任务需要提取和构建表格和收据的文本内容。这些任务是一个序列标记问题,旨在用标签标记每个单词。我们分别使用线性层和 MLP 分类器来预测每个文本标记的最后隐藏状态的标签,用于表格和收据理解任务。

在 FUNSD 数据集和 CORD 数据集上进行了实验。 FUNSD 是从 RVL-CDIP 数据集 中采样的噪声扫描形式理解数据集。 FUNSD 数据集包含 199 个文档,其中包含 9,707 个语义实体的综合注释。我们专注于 FUNSD 数据集上的语义实体标记任务,为每个语义实体分配“问题”、“答案”、“标题”或“其他”之间的标签。训练和测试部分分别包含 149 个和 50 个样本。 CORD是一个收据关键信息提取数据集,在4个类别下定义了30个语义标签。它包含 800 个训练、100 个验证和 100 个测试示例的 1,000 个收据。使用官方提供的图像和 OCR 注释。我们对FUNSD 的学习率为 1e − 5,批量大小为 16,CORD 的学习率为 5e − 5 和 64微调LayoutLMv3 1,000 步。

报告此任务的 F1 分数。对于大模型尺寸,LayoutLMv3 在 FUNSD 数据集上获得了 92.08 的 F1 分数,显着优于 StructuralLM [28] 提供的 85.14 的 SOTA 结果。请注意,LayoutLMv3 和 StructuralLM 使用段级布局位置,而其他作品则使用字级布局位置。使用段级位置可能有利于 FUNSD [28] 上的语义实体标记任务,因此两种类型的工作不能直接比较。 LayoutLMv3 还在 CORD 数据集上的基本模型尺寸和大型模型尺寸上获得了 SOTA F1 分数。结果表明,LayoutLMv3 可以显着有益于以文本为中心的表单和收据理解任务。

任务二:文档图像分类。

文档图像分类任务旨在预测文档图像的类别。

将特殊分类标记 ([CLS]) 的输出隐藏状态输入 MLP 分类器以预测类标签。

在 RVL-CDIP 数据集上进行实验。它是 IIT-CDIP 集合的子集,标记有 16 个类别 。 RVL-CDIP数据集包含400,000张文档图像,其中320,000张是训练图像,40,000张是验证图像,40,000张是测试图像。我们使用 Microsoft Read API 提取文本和布局信息。我们将 LayoutLMv3 微调为 20,000 个步骤,批量大小为 64,学习率为 2e − 5。

评价指标是总体分类准确率。 LayoutLMv3 使用比以前的作品小得多的模型尺寸实现了更好或可比的结果。例如,与 LayoutLMv2 相比,LayoutLMv3 在基本模型和大模型尺寸上分别实现了 0.19% 和 0.29% 的绝对改进,并且图像嵌入更加简单(即 Linear 与 ResNeXt101-FPN)。

结果表明,简单的图像嵌入可以在以图像为中心的任务上取得理想的结果。

任务三:文档视觉问答

文档视觉问答需要一个模型将文档图像和问题作为输入并输出答案。我们将此任务形式化为提取式 QA 问题,其中模型通过使用二元分类器对每个文本标记的最后隐藏状态进行分类来预测开始和结束位置。

在 DocVQA 数据集上进行了实验,这是一个用于文档图像视觉问答的标准数据集。 DocVQA 数据集的官方分区分别包含 10,194/1,286/1,287 个图像和 39,463/5,349/5,188 个训练/验证/测试集问题。我们在训练集上训练模型,在测试集上评估模型,并将结果提交到官方评估网站来报告结果。我们使用 Microsoft Read API 从图像中提取文本和边界框,并使用启发式方法在提取的文本中查找给定答案,如 LayoutLMv2 中所示。

将 LayoutLMv3BASE 微调为 100,000 个步骤,批量大小为 128,学习率为 3e − 5,预热比率为 0.048。对于 LayoutLMv3LARGE,步长、批量大小、学习率和预热比率分别为 200,000、32、1e − 5 和 0.1。报告了常用的基于编辑距离的度量 ANLS(也称为平均标准化编辑相似度)。 LayoutLMv3BASE 将 LayoutLMv2BASE 的 ANLS 分数从 78.08 提高到 78.76,图像嵌入更加简单(即从 ResNeXt101-FPN 到线性嵌入)。与 LayoutLMv3BASE 相比,LayoutLMv3LARGE 进一步获得了 4.61 的绝对 ANLS 分数。结果表明LayoutLMv3对于文档视觉问答任务是有效的。

2.3 视觉任务的微调

为了演示 LayoutLMv3 从多模态域到视觉域的通用性,我们将 LayoutLMv3 转移到文档布局分析任务。此任务是通过提供边界框和类别(例如表格、图形、文本等)来检测非结构化数字文档的布局。此任务有助于将文档解析为下游应用程序的机器可读格式。我们将此任务建模为没有文本嵌入的对象检测问题,这在现有工作中是有效的。

将 LayoutLMv3 作为 Cascade R-CNN 检测器中的特征骨干与使用 Detectron2 实现的 FPN 集成。我们采用标准做法从不同的 Transformer 层中提取单尺度特征,例如 LayoutLMv3 基础模型的第 4、6、8 和 12 层。我们使用分辨率修改模块将单尺度特征转换为多尺度 FPN 特征 。

在 PubLayNet 数据集上进行实验。该数据集包含带有边界框和多边形分割注释的研究论文图像,跨五个文档布局类别:文本、标题、列表、图形和表格。官方分割包含 335,703 个训练图像、11,245 个验证图像和 11,405 个测试图像。

按照标准实践 在训练分割上训练我们的模型,并在验证分割上评估模型。使用 AdamW 优化器对模型进行 60,000 个步骤的训练,在 DiT之后进行 1,000 个预热步骤和 0.05 的权重衰减。由于 LayoutLMv3 是通过视觉和语言模态的输入进行预训练的,因此根据经验使用较大的批量大小 32 和较低的学习率 2e − 4。

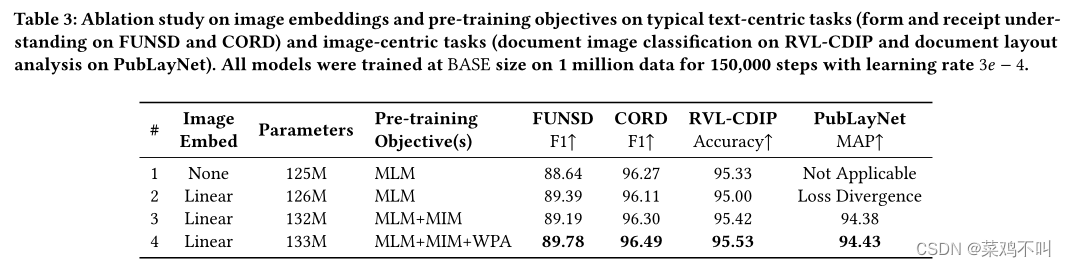

2.4 消融研究

在表 3 中,研究了图像嵌入和预训练目标的效果。首先构建一个基线模型#1,它使用文本和布局信息,并通过 MLM 目标进行预训练。然后使用线性投影图像块作为基线模型的图像嵌入,表示为模型#2。进一步使用 MIM 和 WPA 目标逐步预训练模型 #2,并将新模型分别表示为 #3 和 #4。

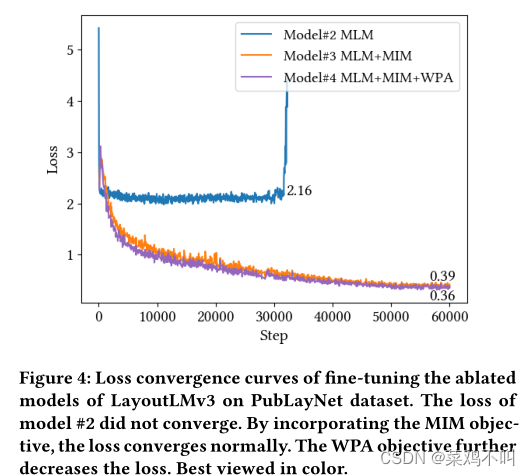

在图 4 中,可视化了模型 #2、#3 和 #4 在 PubLayNet 数据集上进行微调时的损失,批量大小为 16,学习率为 2e − 4。尝试训练模型 # 2,学习率为 {1e − 4, 2e − 4, 4e− 4},批量大小为 {16, 32},但模型 #2 的损失没有收敛,并且 PubLayNet 上的 mAP 分数接近零。

线性图像嵌入的效果。

观察到,没有图像嵌入的模型#1 在某些任务上取得了良好的结果。这表明语言模态(包括文本和布局信息)在文档理解中起着至关重要的作用。然而,结果仍然不尽如人意。此外,如果没有视觉模态,模型#1 无法执行一些以图像为中心的文档分析任务。例如,视觉模态对于 PubLayNet 上的文档布局分析任务至关重要,因为边界框与图像紧密集成。我们简单的线性图像嵌入设计与适当的预训练目标相结合,不仅可以持续改进以图像为中心的任务,还可以进一步改进一些以文本为中心的任务。

MIM 预训练目标的效果。

简单地将线性图像嵌入与文本嵌入连接作为模型 #2 的输入会降低 CORD 和 RVL-CDIP 上的性能,而 PubLayNet 上的损失则不同。我们推测,在没有任何与图像模态相关的预训练目标的情况下,该模型无法在线性块嵌入上学习有意义的视觉表示。MIM 目标通过随机屏蔽输入图像块的一部分并在输出中重建它们来保留图像信息直到模型的最后一层,从而缓解了这个问题。比较模型 #3 和模型 #2 的结果,MIM 目标有利于 CORD 和 RVL-CDIP。由于简单地使用线性图像嵌入改进了 FUNSD,因此 MIM 不会进一步对 FUNSD 做出贡献。通过在训练中结合 MIM 目标,在微调 PubLayNet 时损失会收敛,如图 4 所示,并且获得了理想的 mAP 分数。结果表明,MIM 可以帮助规范训练。因此,MIM 对于 PubLayNet 上的文档布局分析等视觉任务至关重要。

WPA 预训练目标的效果。

通过比较表 3 中的模型 #3 和模型 #4,观察到 WPA 目标持续改进所有任务。此外,WPA 目标减少了图 4 中 PubLayNet 上视觉任务的损失。这些结果证实了 WPA 不仅在跨模态表示学习中的有效性,而且在图像表示学习中也有效。

参数比较。

该表显示,将图像嵌入合并到 16×16 面片投影(#1 → #2)仅引入 0.6M 个参数。与 CNN 主干网的参数相比(例如 ResNet-101 的 44M),这些参数可以忽略不计。 MIM头和WPA头在预训练阶段引入了6.9M和0.6M参数。与 MLM 头相比,图像嵌入引入的参数开销是微乎其微的,MLM 头具有 39.2M 参数,文本词汇量为 50,265。在计算参数时,我们没有计算图像分词器的数量,因为分词器是用于生成 MIM 标签的独立模块,但未集成到 Transformer 主干中。

结论

在本文中,提出了 LayoutLMv3 来预训练文档 AI 的多模态 Transformer,它重新设计了 LayoutLM 的模型架构和预训练目标。与Document AI中现有的多模态模型不同,LayoutLMv3不依赖于预先训练的CNN或Faster R-CNN主干来提取视觉特征,显着节省了参数并消除了区域注释。使用统一的文本和图像屏蔽预训练目标:屏蔽语言建模、屏蔽图像建模和字补丁对齐,来学习多模态表示。大量的实验结果证明了 LayoutLMv3 对于以文本为中心和以图像为中心的文档 AI 任务的通用性和优越性,具有简单的架构和统一的目标。在微调阶段不使用翻转或裁剪增强策略以与我们的预训练阶段保持一致。作者不使用自注意力网络中的相对位置作为 DiT。

作者使用边界框的平均精度 (MAP) @ 并集交集 (IOU) [0.50:0.95] 来测量性能,并在表 2 中报告结果。作者与 ResNets和并发视觉 Transformer 骨干做对比。 LayoutLMv3 在所有指标上都优于其他模型,总体 mAP 得分为 95.1。 LayoutLMv3 在“标题”类别中取得了很高的增益。由于标题通常比其他类别小得多,并且可以通过其文本内容进行识别,因此作者将这种改进归因于在预训练 LayoutLMv3 中纳入了语言模态。这些结果证明了LayoutLMv3的通用性和优越性。