2023年电赛E题总结(openCV/c++)

目录

- 1.2023电赛E题题目分析

- 2.图像处理

- 2.1 opencv(c++) 矩形框中心提取

- 2.1.1 图像二值化处理

- 2.1.2 轮廓提取

- 2.1.3 轮廓面积/角的个数求取

- 2.1.4 轮廓偏移

- 2.2 红色激光点的识别

- 3.步进电机的控制

- 总结和思考

- 源码

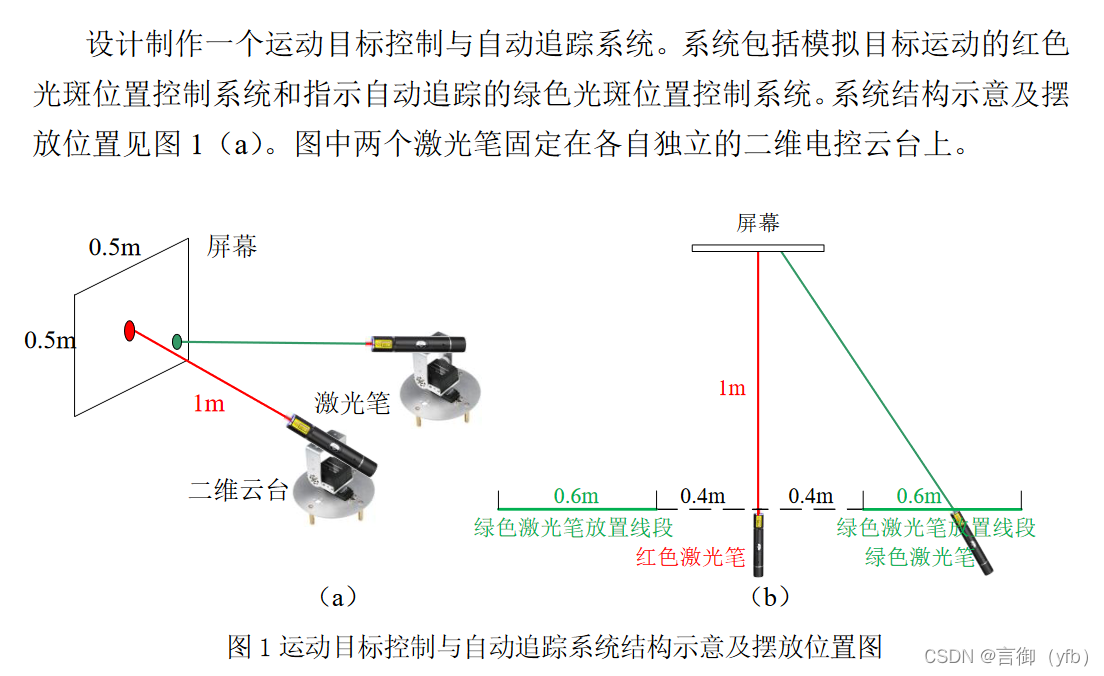

1.2023电赛E题题目分析

本题的主要重点就是识别矩形框,和识别在矩形框上面的红色激光点,然后控制红色激光点。当然也可以不用识别激光点的坐标直接识别矩形框的位置和姿态后直接控制云台走相应的距离也行(虽然凭借这种方式侥幸获得国一),但为了更可加靠这里我还是介绍一下闭环的方案。方案我当初采用的是Sipeed M2dock(主云台)+K210(跟随云台)+stm32控制步进电机云台。

2.图像处理

1.当初比赛时采用的官方的micropython库可以直接识别矩形的边框,经过一番折腾后可以调到能用,但在非常极限的位置的时候仍然不可避免的会走偏。好在裁判没有放在极其偏的位置上面。

2.当然,光识别一个矩形时比赛的要求(几天内完成压力还算大了),如果是识别任意图形呢?

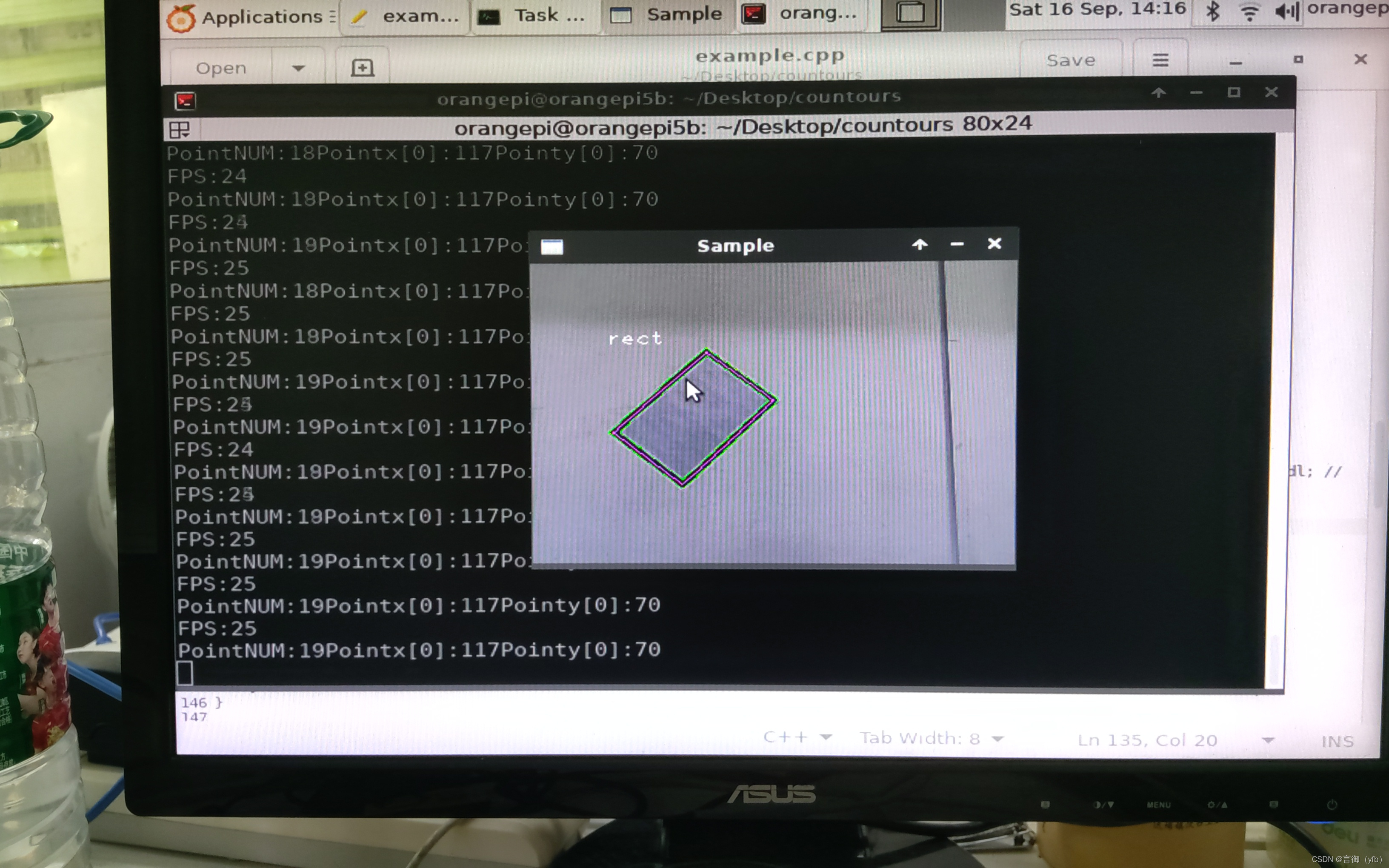

2.1 opencv(c++) 矩形框中心提取

- openMV 或者 K210识别的都是矩形的外边框,而矩形框是有一个宽度的,虽然比赛要求的精度克以大致忽略,但真是的轨迹应是外边框向里面偏移几个像素的位置才是实际的位置。

- 这里我参考了这位大佬的:

opencv轮廓处理

- 主要思路就是: 原始图像 -> 二值化 -> 轮廓提取->轮廓面积求取-> 轮廓角的个数获取 -> 轮廓偏移到矩形中心位置-> 输出轮廓的点集。

2.1.1 图像二值化处理

cvtColor(image, imgGray, COLOR_BGR2GRAY); threshold(imgGray, binImage, 100, 255, cv::THRESH_BINARY_INV); // 转换二值图,设置阈值,高于100认为255`

- 先将原始图像转化为灰度图->再转换为二值化。

2.1.2 轮廓提取

/** * @brief : 检测出物体的轮廓 * @param Mat imgDil 输入图像 * @param contours contours,定义为“vector contours”, * 是一个向量,并且是一个双重向量,向量内每个元素保存了一组由连续的Point点构成的点的集合的向量, * 每一组Point点集就是一个轮廓。有多少轮廓,向量contours就有多少元素。 * @param hierarchy 定义为“vector hierarchy”,先来看一下Vec4i的定义: typedef Vec Vec4i; * Vec4i是Vec的别名,定义了一个“向量内每一个元素包含了4个int型变量”的向量。所以从定义上看, * hierarchy也是一个向量,向量内每个元素保存了一个包含4个int整型的数组。向量hiararchy内的元素和轮廓向量contours * 内的元素是一一对应的,向量的容量相同。hierarchy向量内每一个元素的4个int型变量——hierarchy[i][0] ~hierarchy[i][3], * 分别表示第 i个轮廓的后一个轮廓、前一个轮廓、父轮廓、内嵌轮廓的索引编号。如果当前轮廓没有对应的后一个轮廓、前一个轮廓、 * 父轮廓或内嵌轮廓的话,则hierarchy[i][0] ~hierarchy[i][3]的相应位被设置为默认值-1。 * @param mode 定义轮廓的检索模式: * 取值一:CV_RETR_EXTERNAL只检测最外围轮廓,包含在外围轮廓内的内围轮廓被忽略 * 取值二:CV_RETR_LIST 检测所有的轮廓,包括内围、外围轮廓,但是检测到的轮廓不建立等级关系,彼此之间独立,没有等级关系, * 这就意味着这个检索模式下不存在父轮廓或内嵌轮廓,所以hierarchy向量内所有元素的第3、第4个分量都会被置为-1,具体下文会讲到 * 取值三:CV_RETR_CCOMP 检测所有的轮廓,但所有轮廓只建立两个等级关系,外围为顶层,若外围内的内围轮廓还包含了其他的轮廓信息, * 则内围内的所有轮廓均归属于顶层。 * 取值四:CV_RETR_TREE, 检测所有轮廓,所有轮廓建立一个等级树结构。外层轮廓包含内层轮廓,内层轮廓还可以继续包含内嵌轮廓。 * @param method 定义轮廓的近似方法: * 取值一:CV_CHAIN_APPROX_NONE 保存物体边界上所有连续的轮廓点到contours向量内 * 取值二:CV_CHAIN_APPROX_SIMPLE 仅保存轮廓的拐点信息,把所有轮廓拐点处的点保存入contours * 向量内,拐点与拐点之间直线段上的信息点不予保留 * 取值三和四:CV_CHAIN_APPROX_TC89_L1,CV_CHAIN_APPROX_TC89_KCOS使用teh-Chinl chain 近似算法 * @param offset Point偏移量: * 所有的轮廓信息相对于原始图像对应点的偏移量,相当于在每一个检测出的轮廓点上加上该偏移量,并且Point还可以是负值! * @retval: None */ findContours(Mat image, OutputArrayOfArrays contours, OutputArray hierarchy, int mode, int method, Point offset = Point());2.1.3 轮廓面积/角的个数求取

// 该函数计算轮廓的长度,后面的bool值表面轮廓曲线是否闭合若为true 则轮廓曲线闭合 arcLength(contours[i], true); //计算轮廓面积 contourArea(contours[i]); // conpoly 同样为轮廓点集但它第二个数组中只有1-9个参数为了描述各个轮廓的拐角点 // conpoly[i]是输出array 0.02*peri 这个参数理解不了就不要理解!!!最后一个参数仍然是询问是否闭合 approxPolyDP(contours[i], conpoly[i], 0.02f * peri, true); // 输出图像轮廓中的拐角点数和面积 cout float SAFELINE = scalar; std::vector int next = (i == (count - 1) ? 0 : (i + 1)); dpList.emplace_back(in.at(next) - in.at(i)); float unitLen = 1.0f / sqrt(dpList.at(i).dot(dpList.at(i))); ndpList.emplace_back(dpList.at(i) * unitLen); } for (int i = 0; i

- 先将原始图像转化为灰度图->再转换为二值化。

- 主要思路就是: 原始图像 -> 二值化 -> 轮廓提取->轮廓面积求取-> 轮廓角的个数获取 -> 轮廓偏移到矩形中心位置-> 输出轮廓的点集。

文章版权声明:除非注明,否则均为主机测评原创文章,转载或复制请以超链接形式并注明出处。