Ceph: vdbench 测试ceph存储rbd块设备

目录

2.搭建ceph

3.vdbench环境

准备

笔记本架构:x86 i5 8 代

虚拟化软件:virtualBox 7.0

操作系统:CentOS Linux release 7.9.2009 (Core)

测试虚拟机操作系统:CentOS Linux release 7.9.2009 (Core)

| 节点 | 外部网络 | 内部网络 |

| Server205 | 172.17.11.205 | 192.168.56.101 |

| Server206 | 172.17.11.206 | 192.168.56.108 |

| Server207 | 172.17.11.207 | 192.168.56.109 |

节点之间做主机名映射

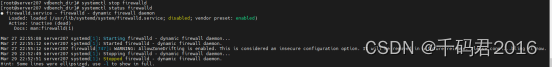

为了省事,关闭防火墙

节点之间做ssh免密互信,注意每个节点都执行以下命令:

Ssh-keygen -t rsa

Ssh-copy-id server20*

每个节点检测java环境喝pip环境,如无请安装

Yum install java -y

Yum install -y python-pip

节点间同步时间,每个节点都执行:

Yum install ntpdate

为了省事,直接同步aliyun的时间,每个节点执行:

ntpdate ntp.aliyun.com

思想准备:

每个节点上的数据盘符和数据盘数量尽量保持一致

三节点上的3副本上创建的块存储,在默认情况下只能有3分之一的容量可用

2.搭建ceph

Ceph版本:2.0.1

Ceph工作流程概要:

最小的存储单元是object,object分组为pg,pg是ceph分布式核心设计,因为其可以在离客户端最近的osd上进行注册。Osd是ceph的核心程序是最基础的请求响应的进程服务,osd将注册在集群cluster map中,客户端通过访问map获取离自己最接近的osd位置,然后与其建立直接通信,最终在数据网络中形成客户端到具体服务进程的P2P的请求相应模式。客户端和osd是多对多关系,osd分布在不同的宿主机上,通过crush算法进行数据的位置分配,并通过ec,通过多副本和EC校验完成数据的可靠性和一致性。

ceph是高性能,高兼容性的统一存储,提供对象、块、文件的存储。本次测试主要针对块设备。块设备在服务器中体现为rbd进程服务,在集群创建好之后,首先需要创建一个资源池,将节点上的数据盘进行接管,然后通过rbd进程进一步将其划分为不同的块文件,最终将rbd挂载在不同的文件目录下完成云硬盘的创建,保障虚拟机磁盘生效和运行。

本册ceph搭建、以及存储池的创建,rbd的创建请参考“aa一叶知秋aa”博主的连接,其中有我时间过程中的问题和知识点交流过程,可以参考:

Ceph分布式存储系统的介绍及详细安装部署过程:详细实战版(保姆级)_存储部署-CSDN博客

Ceph----RBD块存储的使用:详细实践过程实战版-CSDN博客

Ceph的监控工具Dashboard安装部署,详细实战过程_ceph dashboard启动-CSDN博客

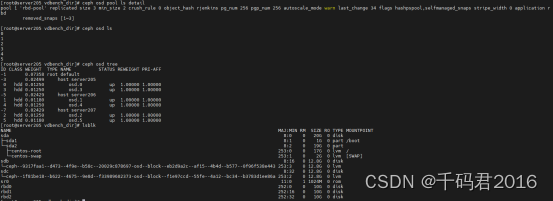

- RBD分布状态,三个节点都应如下现象是正确的

3.vdbench环境

下载vdbench:

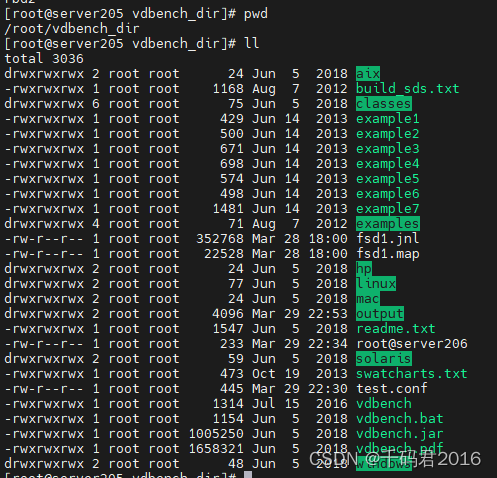

解压到每个节点并安装固定的目录下

这里提供vdbench的学习网址一篇:

【ceph】vdbench的使用教程——裸盘测试和文件系统测试vdbanch - bdy - 博客园 (cnblogs.com)

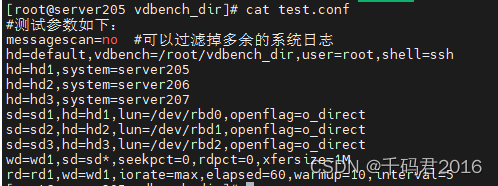

在这里分享一下我的test配置文件

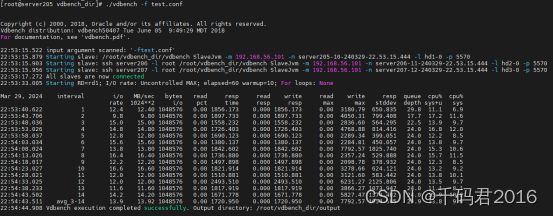

- 附带配置文件 执行vdbench

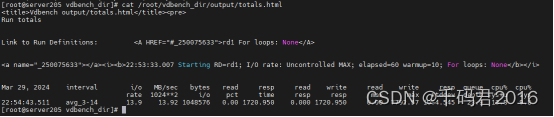

以下是最终分析结果

.png)