Spring AI 使用本地 Ollama Embeddings

使用 OpenAI 的 Embeddings 接口是有费用的,如果想对大量文档进行测试,使用本地部署的 Embeddings 就能省去大量的费用,所以我们尝试使用本地的 Ollama Embeddings。

首先本地安装 Ollama: https://ollama.com/download

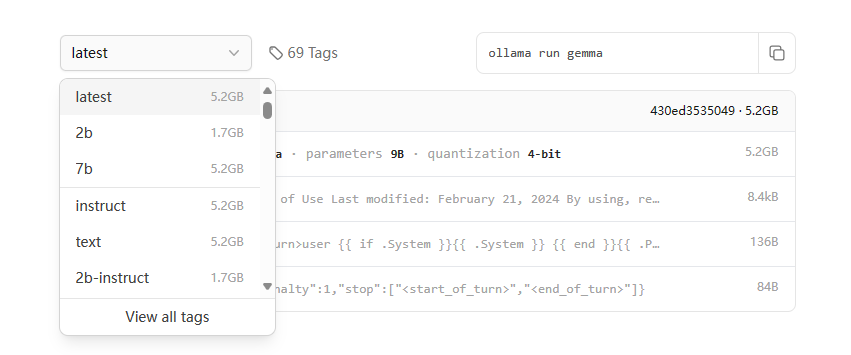

即使你电脑没有性能很强的显卡,仅仅依靠 CPU 也能运行一些参数量较小的模型。ollama 中下载量最多的是 llama2 模型,但是这个模型对中文支持不太好,我们可以试试 Google 开源的 gemma 模型:

https://ollama.com/library/gemma

这个模型包含几个不同的版本,默认为 7b 的版本,可以先试试 7b,如果速度太慢可以换 2b 试试,执行命令 ollama run gemma 时会下载模型并运行,模型默认会下载到用户目录中的 .ollama 中,如果用户目录(一般在C盘)所在盘空间少,可以提前通过环境变量方式修改位置,参考下面的配置(改成自己的路径):

OLLAMA_MODELS=D:\.ollama

如果不会在 Windows 创建 .前缀的目录,也可以用正常目录,也可以打开 git bash,使用命令 mkdir .ollama 创建

配置环境变量后一定打开一个新的 CMD 或者 Terminal,然后执行 ollama rum gemma 下载并启动模型(已经下载到用户目录的模型可以整体移动到新的目录)。启动后可以在控制台进行对话,如下所示:

>ollama run gemma >>> 你好 你好!我很好,谢谢您的问候。 您想让我做什么呢?我能够帮助您吗?

接下来在 Spring AI 中使用该模型,首先引入Maven依赖:

org.springframework.ai spring-ai-ollama-spring-boot-starter

通过下面示例代码运行:

var ollamaApi = new OllamaApi();

var chatClient = new OllamaChatClient(ollamaApi).withModel("gemma")

.withDefaultOptions(OllamaOptions.create()

.withModel("gemma")

.withTemperature(0.9f));

Scanner scanner = new Scanner(System.in);

while (true) {

System.out.print(">>> ");

String message = scanner.nextLine();

if (message.equals("exit")) {

break;

}

String resp = chatClient.call(message);

System.out.println("

文章版权声明:除非注明,否则均为主机测评原创文章,转载或复制请以超链接形式并注明出处。

.png)