Hadoop上传文件到HDFS的步骤

目录

前言:

1.启动Hadoop集群:

2. 打开终端或命令行界面:

在安装了Hadoop的服务器上,打开一个终端或命令行界面。

3.使用hdfs dfs命令上传文件: 使用hdfs dfs -put命令将本地文件上传到HDFS。命令的基本格式如下:

例如,如果你想将本地的/home/user/data.txt文件上传到HDFS的/user/hadoop/data/目录下,你可以运行以下命令:

如果你只想上传文件到HDFS的根目录,并保留其原始文件名,你可以这样做:

4.验证文件是否成功上传:

5.删除HDFS上的文件:

结论:

前言:

随着大数据时代的到来,数据存储和处理变得至关重要。Hadoop作为大数据处理的基石,其分布式文件系统HDFS提供了高效、可靠的数据存储方案。本文旨在简要介绍如何使用Hadoop命令行工具将文件上传到HDFS,为大数据处理提供基础支持。

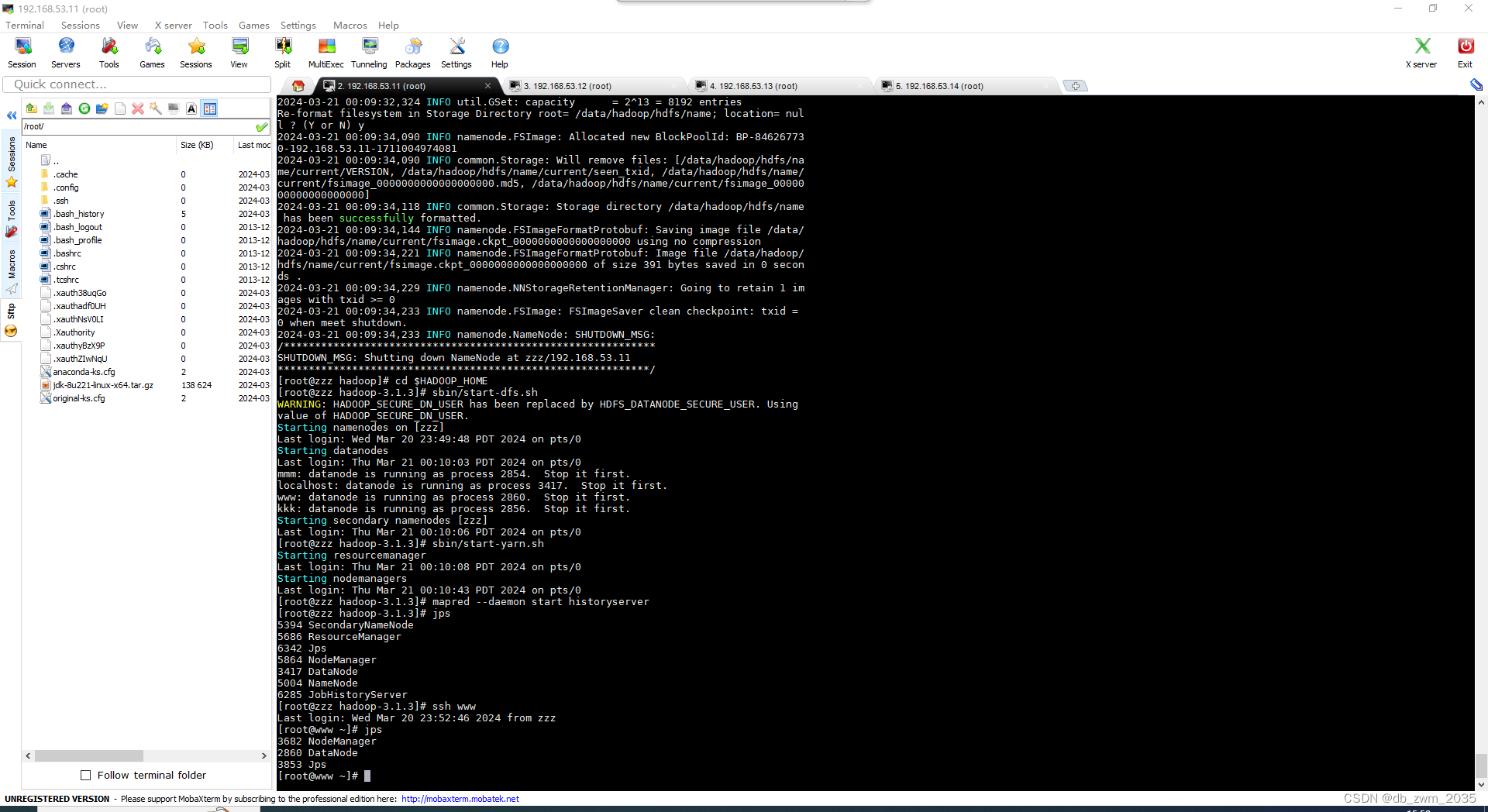

1.启动Hadoop集群:

确保你的Hadoop集群已经启动并且运行正常。你可以通过jps命令查看Hadoop相关的进程是否在运行,如NameNode、DataNode、ResourceManager、NodeManager等。

2. 打开终端或命令行界面:

在安装了Hadoop的服务器上,打开一个终端或命令行界面。

3.使用hdfs dfs命令上传文件:

使用hdfs dfs -put命令将本地文件上传到HDFS。命令的基本格式如下:

hdfs dfs -put

其中:

- 是你要上传的本地文件的路径。

- 是HDFS上的目标路径,包括文件名。如果目标路径是一个目录,那么文件将被上传到该目录下,并保留其原始文件名。

例如,如果你想将本地的/home/user/data.txt文件上传到HDFS的/user/hadoop/data/目录下,你可以运行以下命令:

hdfs dfs -put /home/user/data.txt /user/hadoop/data/

如果你只想上传文件到HDFS的根目录,并保留其原始文件名,你可以这样做:

hdfs dfs -put /home/user/data.txt /

注意:如果HDFS上的目标路径已经存在同名文件,hdfs dfs -put命令会覆盖它。

4.验证文件是否成功上传:

你可以使用hdfs dfs -ls命令来列出HDFS上的文件和目录,以验证文件是否已成功上传。例如:

hdfs dfs -ls /user/hadoop/data/

这将列出/user/hadoop/data/目录下的所有文件和子目录。你应该能在其中看到你刚刚上传的data.txt文件。

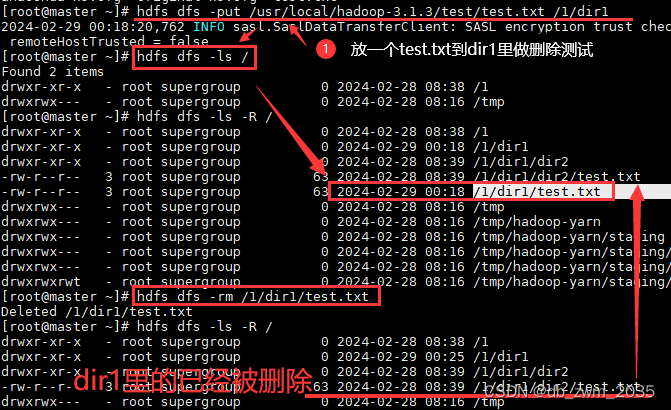

5.删除HDFS上的文件:

如果你需要删除HDFS上的文件,可以使用hdfs dfs -rm命令。例如:

hdfs dfs -rm /user/hadoop/data/data.txt

例1:不带-r的。输入命令: hdfs dfs -rm /1/dir1/test.txt

请注意,hdfs dfs -rm命令会永久删除HDFS上的文件,所以请谨慎使用。

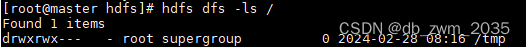

6.显示HDFS指定路径下的所有文件

①hdfs dfs -ls

例:hdfs dfs -ls /

查看文件

hdfs dfs -cat

结论:

通过本文的介绍,我们了解了如何使用Hadoop的命令行工具将文件上传到HDFS,这是大数据处理流程中的关键一步。HDFS作为Hadoop的核心组件,为大数据存储提供了可靠、高效的解决方案。掌握这一技能,对于从事大数据相关领域的工作者来说至关重要,它将有助于我们更好地处理和分析大规模数据集,从而挖掘出有价值的信息。

.png)