yolov5s模型剪枝详细过程(v6.0)

温馨提示:这篇文章已超过449天没有更新,请注意相关的内容是否还可用!

本文参考github上大神的开源剪枝项目进行学习与分享,具体链接放在文后,希望与大家多多交流!

一、原模型训练

在官方源码上训练yolov5模型,支持v6.0分支的n/s/m/l模型,我这里使用的是v5s,得到后将项目clone到本机上

git clone https://github.com/midasklr/yolov5prune.git

cd进入文件夹后,新建runs文件夹,将训练好的模型放入runs/your_train/weights/xxx.pt,我的原模型map0.5:0.95为0.84左右,模型与data.yaml设置好后可以进行稀疏化训练了。

二、稀疏化训练

python train_sparity.py --st --sr 0.0002 --weights yolov5s.pt --data data/your_data.yaml --epochs 100 --imgsz 512 --adam ...

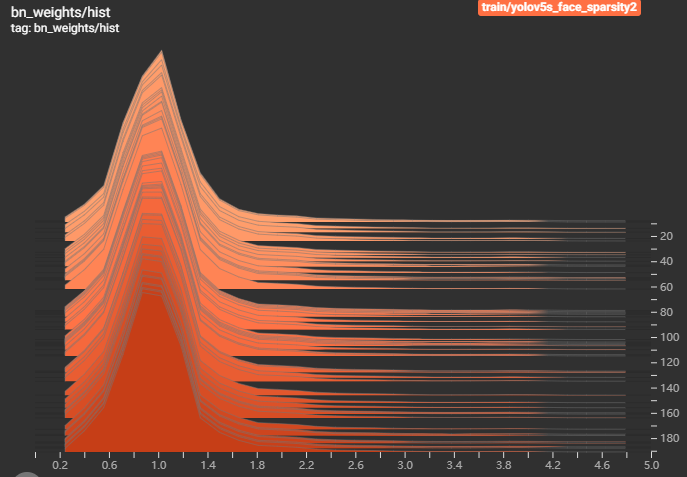

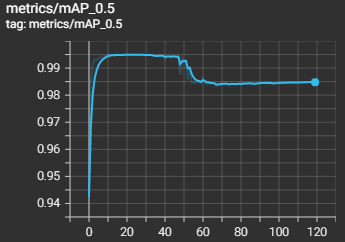

注意:1、若原模型训练时未使用adam,则这里也不要使用adam。2:data.yaml文件改成自己的数据集文件。3:这里sr参数为稀疏化系数,具体值为多少根据不同的数据集和模型,一般设置不一样,需要自己多试试,比如我的是单类别目标检测,设置为0.0002时几乎不变化(如下图)。

这里我们cd到runs文件夹路径,然后输入tensorboard实时监看训练过程,logdir也指向runs文件夹即可,然后打开网页输入你的ip,端口号一般为6006,比如192.168.xx.xx:6006就可以监看。

tensorboard --logdir=/home/user2/yinjiacheng/pytorch-ssd/pytorch-ssd/runs --host=0.0.0.0

这个直方图的纵轴代表训练次数(从上往下训练次数增加),横轴的峰值应随着训练次数不断逼近0轴,代表着大多数bn已经变得稀疏,而出现下图这个情况或者稀疏过慢(逼近0轴的过程缓慢)时,代表sr值应该适量增大。

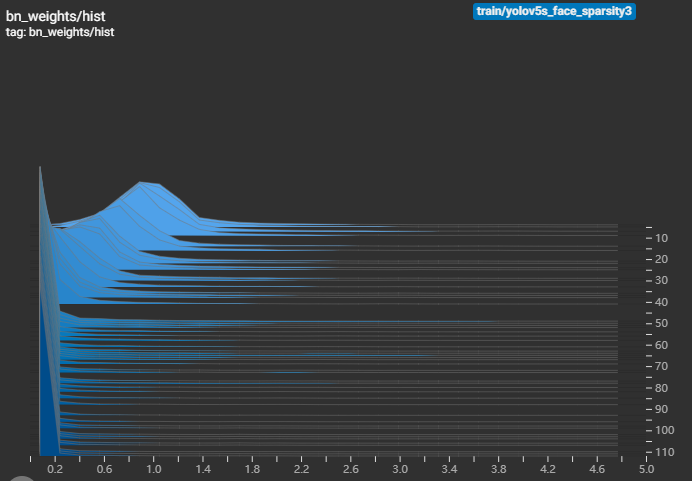

所以我调整了sr为0.02,但此时bn收敛过快,且mAP下降严重,如下图所示,表示sr值调的过大了,需要适当减少,直至直方图逼近0轴的同时,mAP与原模型相差不大。

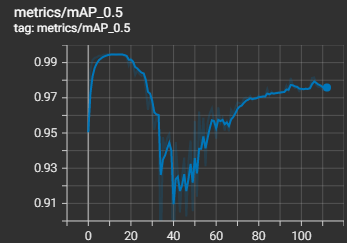

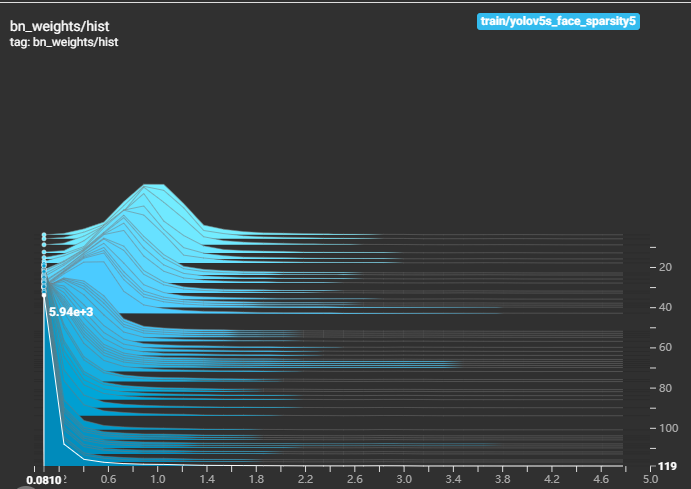

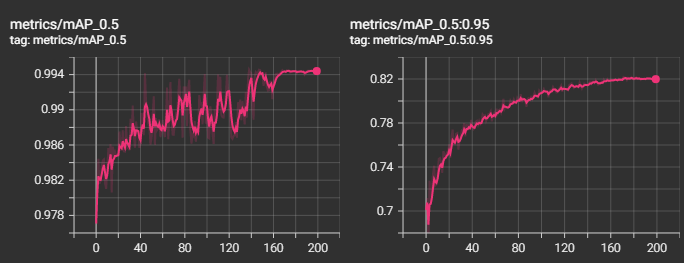

然后我将sr值调整为0.01,此时的bn直方图与mAP0.5曲线如下图所示:

可以看出bn直方图往0轴逼近的速度不是太快也不是太慢(好像在说废话),而mAP虽然有掉点但还是可以接受,最后可以finetune回来一些,所以可以选择这一稀疏化模型进行下一步的剪枝。

三、剪枝

python prune.py --percent 0.5 --weights runs/train/exp/weights/last.pt --data data/your_data.yaml --cfg models/yolov5s.yaml

这里percent参数是剪枝比例,weights选择刚刚训练好的稀疏化模型,cfg选择你使用的yaml即可,剪枝完成后主文件夹下会出现pruned_model.pt文件,这就是剪枝后的模型,但会发现怎么模型大小下降的不多,因为它还是FP32精度的,而我们yolov5训练完成后的模型为FP16精度,所以其实大小还是下降挺多的(最后我微调后得到的是5.8M,而原模型为13.6M)。

四、微调

python finetune_pruned.py --weights pruned_model.pt --data data/your_data.yaml --epochs 150 --imgsz 320 --adam

这里还是一样,若前面没有使用adam则这里也不要用,imgsz调成自己的输出尺寸,200个epoch还是finetune回来不少的。

最后我获得的模型为5.48M,参数量Param为2.74M,输入尺寸为320*320时FLOPs为2.17G,比原模型大小13.6M,FLOPs为3.9G明显减小。

五、detect

该项目中的detect.py和detectpruned.py代码有些问题,大家可以把微调后的pt模型放到官方项目中去detect,但有几点需要改。

现在我们是两个项目,一个是剪枝的yolov5_prune,一个是官方的yolov5,将yolov5_prune/model/pruned_common.py文件复制到官方yolov5/model/ 中去。

将pruned_common.py中第26行的

from utils.plots import Annotator, colors, save_one_box

save_one_box删掉,再在25行最后加上,因为在官方文件中save_one_box这个def是在utils下的general中定义的。

from utils.general import (LOGGER, check_requirements, check_suffix, check_version, colorstr, increment_path,make_divisible, non_max_suppression, scale_coords, xywh2xyxy, xyxy2xywh,save_one_box)

打开官方yolov5/utils/general.py,在第43行后,也就是声明第一个class前加上以下代码

def set_logging(name=None, verbose=True):

# Sets level and returns logger

for h in logging.root.handlers:

logging.root.removeHandler(h) # remove all handlers associated with the root logger object

rank = int(os.getenv('RANK', -1)) # rank in world for Multi-GPU trainings

logging.basicConfig(format="%(message)s", level=logging.INFO if (verbose and rank in (-1, 0)) else logging.WARNING)

return logging.getLogger(name)

LOGGER = set_logging(__name__) # define globally (used in train.py, val.py, detect.py, etc.)

最后根据设置运行detect.py即可,我在detect中加了将漏报和误报图片分别放在不同文件夹的功能,最后在5000张val集中分别多了几十张吧,还算可以接受。

python detect.py --weights runs/train/yolo5s_face_prune/weights/last.pt --conf 0.5 --img-size 320 --source data/your_data/images/val --save-txt

参考链接:midasklr/yolov5prune at v6.0 (github.com)